La GPU NVIDIA B100 usará memoria HBM3E

Los rumores apuntan a que veremos la GPU NVIDIA B100 con HBM3E para el 2024, por lo que la gama HPC se renovará de la marca verde se renovará el año que viene con nuevas capacidades y motivada por la demanda creciente de la H100 por el auge de la IA generativa y otras aplicaciones derivadas del Machine Learning.

Índice de contenidos

NVIDIA lanzará su GPU B100 con memoria HBM3E en 2024

Al menos esto es lo que dice el último rumor, y es que la empresa de Jensen Huang habría llegado a un acuerdo con el fabricante de memoria SK Hynix para que este último sea el proveedor de la memoria de la próxima GPU para computación de alto rendimiento e inteligencia artificial. En todo caso, cabe aclarar que no nos referimos al chip que veremos en las próximas GeForce, el cual es el GB202, sino al sucesor del actual H100, la cual además, por motivos de demanda se habría adelantado al segundo trimestre de 2024.

Y es que si la información es cierta, se usará memoria HBM3E en la GPU NVIDIA GB100, de la cual por el momento se sabe lo siguiente:

- Por primera vez veremos una GPU disgregada por parte de NVIDIA en el mercado HPC, por lo que esto indica que la suma de sus partes superará los 838 mm² que es el límite de la retícula.

- Según Kopite7Kimi, uno de los filtradores más fiables, la configuración recuerda a la MI200 de AMD, es decir, dos GPU simétricas acompañadas de 8 pilas de memoria, en este caso HBM3E.

La memoria HBM3E puede transmitir hasta 8 Gbps por cada uno de los 1024 pines de datos que tiene cada pila, por lo que cada chip de esta memoria montado sobre el Interposer puede alcanzar 1 TB/s de ancho de banda sin problemas. Sí el bus de datos es de 8144 bits, entonces estaríamos hablando de una bestia que se comunicaría con su RAM a 8 TB/s de velocidad. Y que podría alcanzar sin problemas los 192 GB de capacidad.

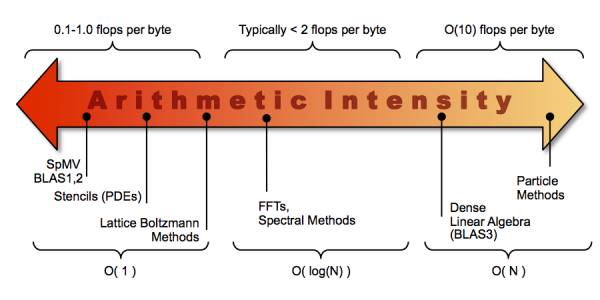

Bytes/FLOP

Hemos de partir de la GPU B100 de NVIDIA con HBM3E no va a utilizarse para juegos, sino para ejecutar algoritmos científicos y de inteligencia artificial que requieren procesar una gran cantidad de datos. En este punto es donde entra el concepto B/F o Bytes por FLOP, que no es otra cosa que la relación entre la capacidad de computación respecto al ancho de banda de la memoria externa.

La idea es que para ejecutar ciertos algoritmos con la suficiente soltura no es suficiente con aumentar la capacidad de cálculo de la GPU, sino que la memoria ha de ir a la par. Tristemente la tendencia, y debido a que la RAM no avanza tan rápidamente como los procesadores, es que el valor B/F ha ido disminuyendo, lo cual dificulta el avance. Es decir, en la actualidad las GPU, en especial en el mundo HPC e IA, están más limitadas por memoria, ya sea capacidad, latencia o ancho de banda, que no por capacidad de cálculo.

Si bien los arrays sistólicos procesan en su misma memoria, hemos de partir que hay operaciones que no se realizan como multiplicaciones de matrices y que habitualmente se encuentran limitadas por el acceso a la memoria externa, y tampoco nos podemos olvidar de los algoritmos para computación de alto rendimiento, estos siguen siendo igual de dependientes de la velocidad de transferencia de sus memorias.

[…] cuyo chip parece ser que será el X100 y que veremos en 2025. Justo un año después que el chip B100 que todavía es inédito. Fijaos además cómo tenemos al chip GB200 apuntado como ARM Inference. […]