NVIDIA multiplica por 5 su potencia para IA con sus nuevos chips.

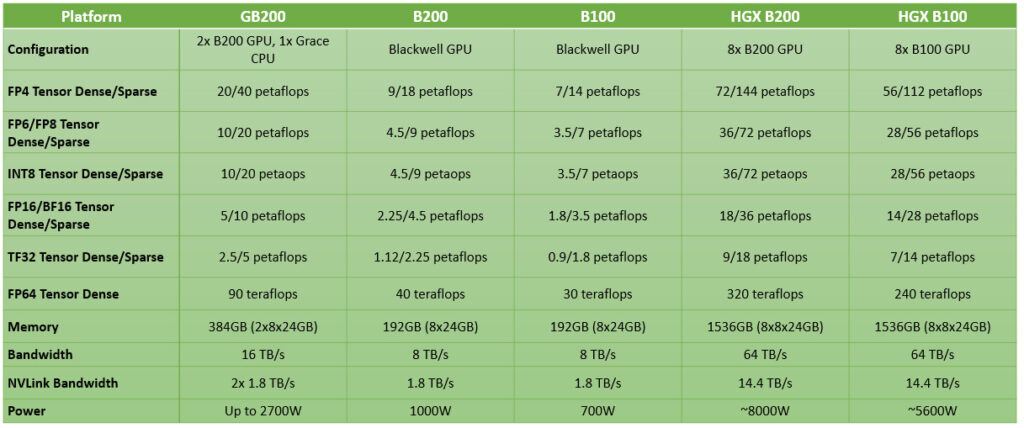

NVIDIA acaba de presentar en la GTC 2024 sus GPU para computación de alto rendimiento bajo arquitectura Blackwell. En concreto, se han presentado: B100, B200 y GB200, así como diferentes configuraciones de hardware utilizando dichos componentes. ¿Cuáles son sus especificaciones técnicas y qué novedades traen respecto a los actuales chips basados en la arquitectura Hopper?

Nota: aún no tenemos toda la información oficial de los chips B100 y B200 de NVIDIA en el momento de escribir este artículo, es por ello que lo iremos actualizando progresivamente este artículo a medida que vaya saliendo nueva información. Así que estad atentos a la

Índice de contenidos

Tabla de contenidos

NVIDIA B100 y B200 con arquitectura Blackwell

Generación tras generación estamos viendo como la estrategia de NVIDIA de lanzar arquitecturas que sirvan tanto para gráficos como computación e IA les es cada vez más difícil. Si bien chips como los futuros B100 y B200, o los actuales H100 y H200, tienen una organización derivada de una GPU, carecen de muchos elementos que son indispensables para generar gráficos a tiempo real. Tampoco les hace falta, dado que su utilidad y mercado objetivo son otros.

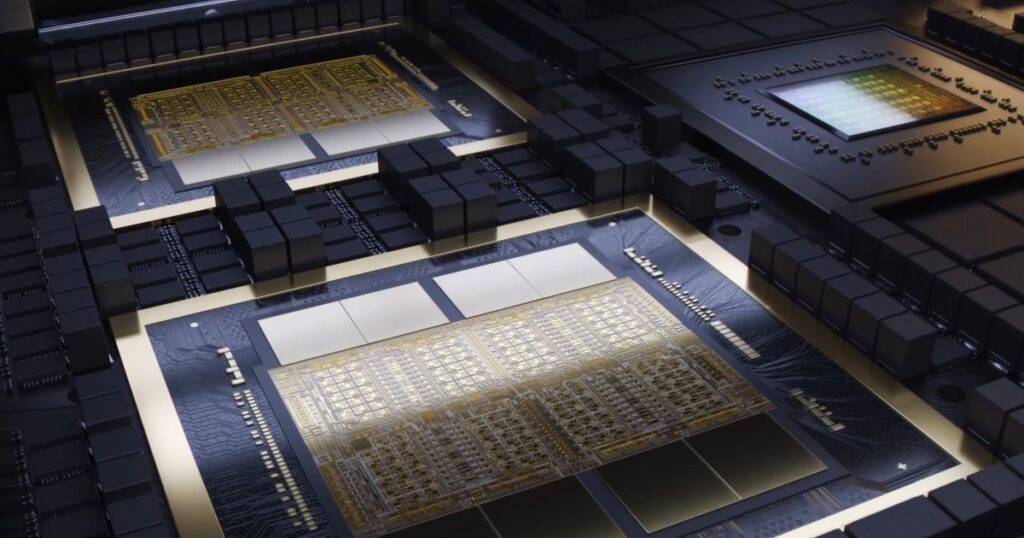

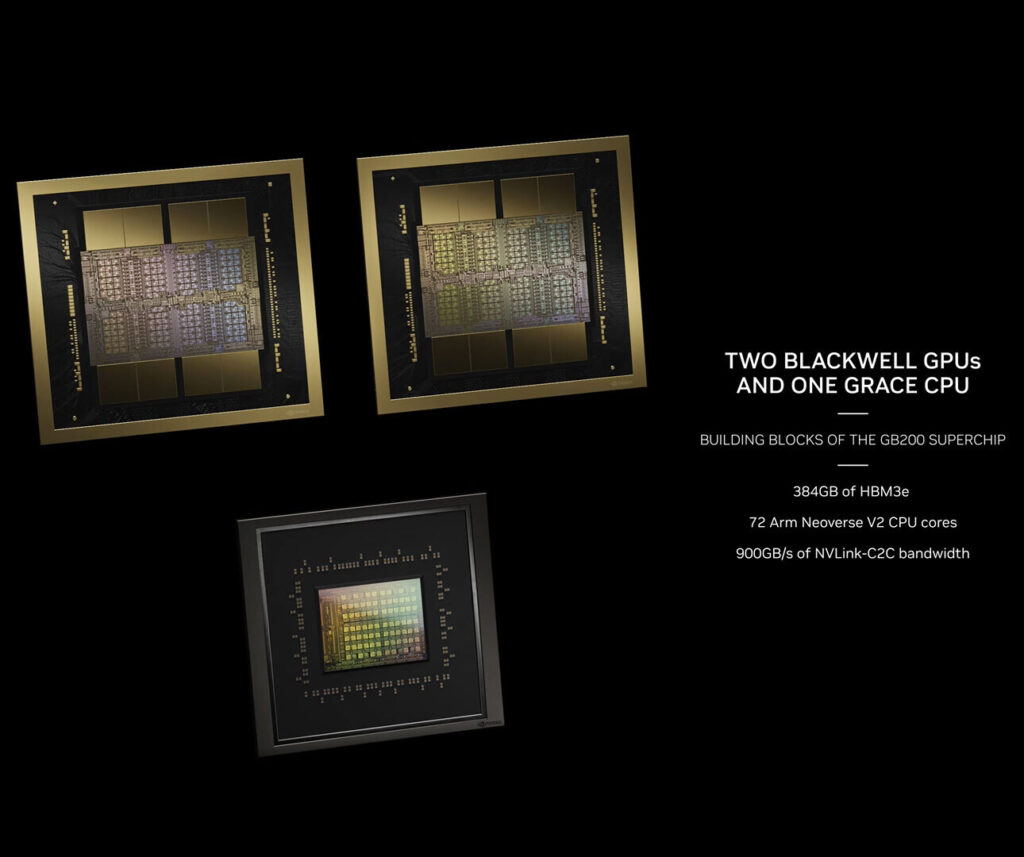

Hemos de partir que B100 y B200 son en realidad el mismo hardware, ambos están compuestos por dos chips fabricados bajo el mismo nodo de 4 nm de TSMC que las H100 y H200, pero con la diferencia que en este caso hablamos no de uno solo, sino dos chips mastodónticos de 814 mm² de área y con una interfaz de memoria que ha pasado de ser de 6 pilas HBM3E a 8 pilas del mismo tipo de memoria. Lo que les permite llegar a los 192 GB de capacidad, frente a los 141 GB de la H200 y los 80 GB de la H100.

El hecho de no haber dado el salto a los 3 nm, tal y como se esperaba nos dice una cosa muy simple: NVIDIA se siente tan segura con su dominio en el mercado de la IA que ha decidido pisar el freno.

¿Un salto no tan espectacular en las GPU B100 y B200?

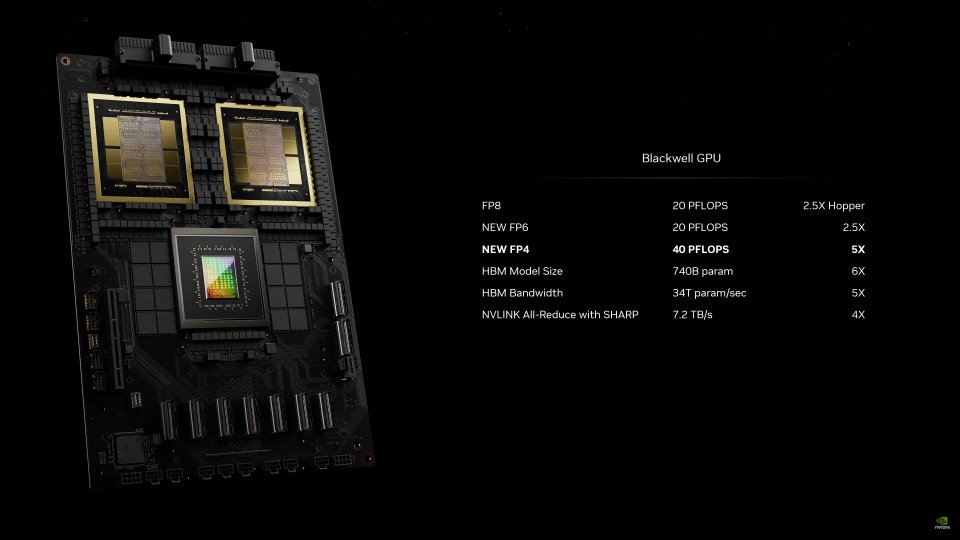

Según NVIDIA, el chip B200 tiene una capacidad de hasta 18 PetaFLOPS de computación para la IA, recordad que 1000 TFLOPS = 1 PFLOPS. Por lo que supone un salto de x5 respecto a lo que ofrece el chip H100. Un salto cuando menos espectacular, pero es que NVIDIA está haciendo trampas

Pero hay una trampa en esto, ya que NVIDIA ha añadido un nuevo formato, el FP4, el cual es coma flotante con precisión de 4 bits, con el cual consiguen un salto de x2 gracias al soporte de SIMD sobre registro que tienen las ALU de los Tensor Cores, además, han añadido otro nuevo formato numérico, el FP6 que es de 6 bits de precisión. Por si fuera poco, la ventaja de la arquitectura Blackwell en los chips NVIDIA B100 y NVIDIA B200 es dos GPU combinadas, en vez una sola, por lo que el salto por chip de una generación a otra es de un 25% más en lo que a potencia de cálculo se refiere.

Ahora bien, la forma en la que NVIDIA ha unido los dos chips no ha sido a través de un interposer, sino utilizando su tecnología NVLink de quinta generación con un ancho de banda de hasta 1.8 TB/s entre chips, la cual es muy superior al ya a punto de desaparecer CXL, al ofrecer un ancho de banda varias veces superior, el cual es indispensable para este tipo de hardware y su dependencia de enormes anchos de banda.

Detalles adicionales de la arquitectura Blackwell

Si bien todavía no hemos visto el whitepaper de la misma, y nos faltan datos de forma oficial, como es el número de núcleos en total, velocidades de reloj y demás detalles. NVIDIA sí que ha adelantado algunas de las nuevas tecnologías que veremos en los chips B100 y B200.

- La nueva arquitectura es compatible con las librerías Transformer Engine de segunda generación. Los chips bajo arquitectura Blackwell soportarán modelos con el doble de tamaño y capacidades de inferencia con precisión de 4 bits.

- RAS Engine: se trata de un chip con la capacidad de automatizar diagnósticos sobre el propio hardware.

- Secure AI: NVIDIA ha añadido nuevas capacidades para encriptar los datos a través de unidades especializadas para ello.

- Decompression Engine: para nosotros la novedad más importante, se trata de una unidad dedicada a poder comprimir y descomprimir datos a gran velocidad, dejando libres a los núcleos de la GPU, para ello, lo veremos en las RTX 50, ya que no deja de ser diferente a las unidades análogas que vemos en consolas.

Dicho de otra forma, NVIDIA ha decidido añadir una serie de aceleradores para que tareas comunes no caigan en la responsabilidad de los núcleos en los chips B100 y B200. Una práctica muy común en el diseño de hardware.

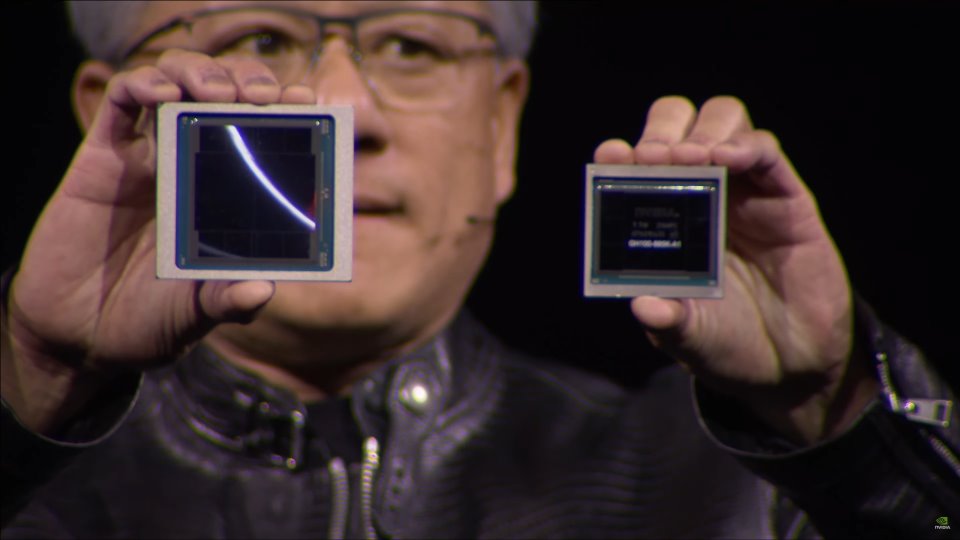

NVIDIA GB200

Al igual que ocurrió con GH100 y GH200, NVIDIA ofrecerá en una sola placa y con todo integrado GB200 junto a la CPU NVIDIA Grace, basada en 72 núcleos ARM Neoverse 2, por lo que al contrario de lo que se esperaba en parte, NVIDIA continua con la misma CPU que hace dos años, la cual viene acompañada con otra interfaz NVLink de quinta generación que le permite comunicarse a 0.9 TB/s con cada uno de los dos chips.

Aquí nos queda muy clara la ventaja de la interfaz de intercomunicación de NVIDIA en comparación con la versión coherente del PCI Express, cuya versión 6.0, aún no disponible, llegará a los 128 GB/s. Por lo que lo de Jensen Huang tienen una ventaja que no solo se encuentra en sus chips, sino también en la intercomunicación, lo que les permite encerrar de por vida a sus clientes a su plataforma.