Unidades de medida en informática: bits, bytes…

Seguimos con nuestros artículos de conceptos básicos, en este caso os traemos una serie de términos básicos que son las unidades de medida y las tasas en informática, las cuales nos sirven para medir cantidades de datos que se almacenan, así como de la velocidad de comunicación.

Índice de contenidos

Unidades de medida

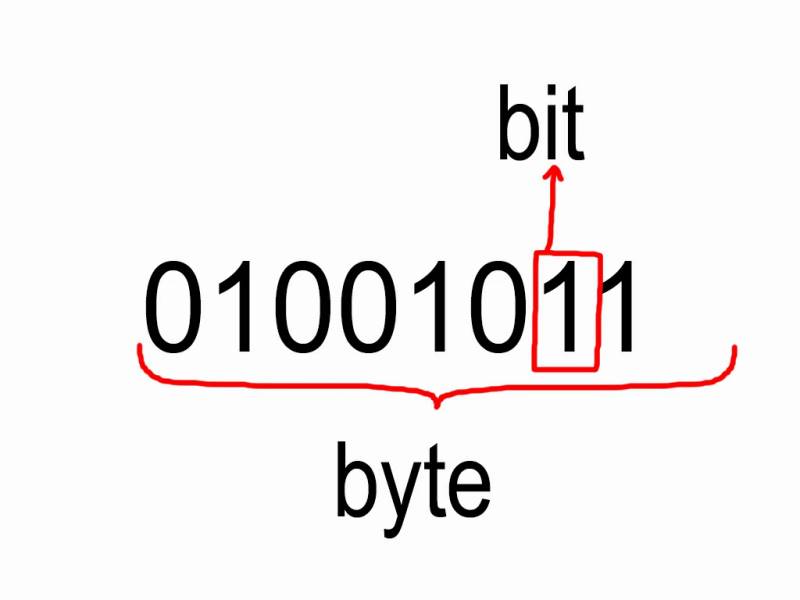

En informática la unidad más pequeña es el bit, el cual es el dato en binario más pequeño que existe, un bit tiene un tamaño de un solo pulso con dos posibles valores: 0 o 1. En cuanto al resto de unidades de medida, la que se estandarizó fue el Byte u octeto, el cual originalmente era de 6 bits, pero por efectos prácticos termino siendo de 8 bits. No hemos de olvidar que en las nomenclaturas se suelen poner los bits en b minúscula, mientras que los bytes en B mayúscula para diferenciarlos.

Ahora bien, dependiendo de si estamos hablando de almacenar datos o transferir datos, los prefijos que nos indican el volumen de información varían en su significado. Esto se debe a que los datos se almacenan en una matriz bidimensional, por lo que en cuanto a unidades para contar el volumen de información, contar de 1000 en 1000 está mal.

| Unidad de medida | Cantidad de Bytes |

| Byte | 10240 |

| Kilobyte | 10241 |

| Megabyte | 10242 |

| Gigabyte | 10243 |

| Terabyte | 10244 |

| Petabyte | 10245 |

| Exabyte | 10246 |

Esto es importante por el hecho que hay marcas que en sus unidades de almacenamiento (discos duros, SSD, tarjetas de memoria) suelen contar la información contando de 1000 en 1000, en vez de 1024 en 1024. Un ejemplo de ello es el SSD del modelo inicial de PlayStation 5, el cual tiene una capacidad de 768 GB según la nomenclatura estándar, pero 825 GB en la errónea, la cual es la publicitada por Sony.

Enteros versus coma flotante

Una vez hemos aprendido lo que son los volúmenes de información, ahora nos toca hablar de la forma en la que los ordenadores almacenan los datos, y es que según el modo utilizado, el código binario puede significar una cosa u otra.

En el artículo de qué es y cómo funciona una CPU de forma simple no lo tuvimos en cuenta, pero podemos tener una copia distinta de cada instrucción, dependiendo del tipo de datos con los que estemos operando, o en su defecto usaran un bit de estado para indicar la condición. Así pues, un byte puede indicar valores entre el 0 y el 255, ya que puede tener 28 valores distintos, pero si hacemos que el primer marca el signo, entonces el valor puede ir de -127 a 127 y nos encontramos con que estamos operando con valores negativos.

No obstante, una cosa que oiréis mucho es lo de enteros y coma flotante, donde lo segundo se utiliza para representar números decimales. El estándar más utilizado es el IEEE-754, donde tenemos los siguientes valores:

- FP16 (Half Precision)

- El primer bit indica el signo.

- Los siguientes 5 bits el exponente, es decir, la parte entera.

- Para terminar, los últimos 10 bits indican la mantisa o la parte decimal del valor.

- FP32 (Single Precision)

- El primer bit indica el signo.

- Los siguientes 7 bits el exponente, es decir, la parte entera.

- Para terminar, los últimos 23 bits indican la mantisa o la parte decimal del valor.

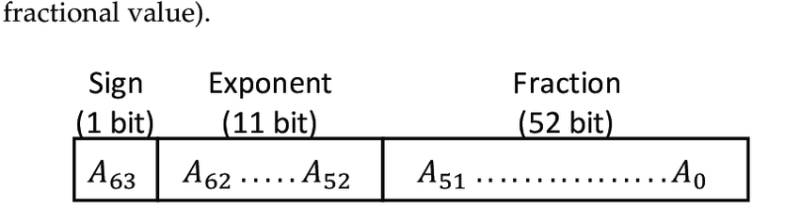

- FP64 (Double Precision)

- El primer bit indica el signo.

- Los siguientes 11 bits el exponente, es decir, la parte entera.

- Para terminar, los últimos 52 bits indican la mantisa o la parte decimal del valor.

Unidades de medida para la inteligencia artificial

Sin embargo, con la llegada de la IA han aparecido nuevos tipos de datos en coma flotante, BFLOAT16 y TF32, que siguen unas normas algo distintas a las del estándar IEEE-754.

- BFLOAT16

- 1 bit para el signo.

- 8 bits para el exponente

- 7 bits para la mantisa.

- TF32

- 1 bit para el signo.

- 8 bits para el exponente

- 23 bits para la mantisa.

Debido a su diferente naturaleza respecto al estándar IEEE-754, estas unidades de medida requieren unidades especializadas o modificadas para poder operar con estas. Sin embargo, a día de hoy su uso se limita al mundo de los chips dedicados a inteligencia artificial o con capacidades ampliadas para ello, como son GPU, NPU y TPU.

Tasas en informática

Hemos de tener en cuenta que una tasa es una medida que describe la relación entre dos cantidades diferentes. En el caso de la informática tenemos dos tipos de tasas distintas: la primera indica el volumen de información respecto al tiempo y es el ancho de banda. Sin embargo, esta se representa de dos formas distintas:

| Tasa | Significado | Valor (en bits) |

| bps | bits por segundo | 1 |

| B/s | bytes por segundo | 8 |

| Kbps | kilobits por segundo | 103 |

| KB/s | kilobytes por segundo | 8 * 103 |

| Mbps | megabits por segundo | 106 |

| MB/s | megabytes por segundo | 8 * 106 |

| Gbps | gigabits por segundo | 109 |

| GB/s | gigabytes por segundo | 8 * 109 |

La tasa son los FLOPS y los OPS, los primeros indican la cantidad de operaciones en coma flotante que realiza una unidad de cálculo en un segundo, mientras que la segunda en enteros. Por lo que ambas no solo son también tasas, sino también unidades de medida que miden la velocidad de cálculo de un procesador, ya sea de propósito general como una CPU o para tareas más específicas, como es el caso, por ejemplo, de las GPU.