Guerra de la IA entre Intel y NVIDIA, Pat Gelsinger menosprecia el éxito de su rival

A ninguna empresa le gusta perder y cuando tenemos a una empresa que tiene el 80% del mercado de las CPU para PC, siendo relegada a la nada en lo que al mercado de hardware para Deep Learning y Machine Learning. En medio de todo esto, Pat Gelsinger ha empezado una Guerra de la IA entre Intel y NVIDIA, al menos de palabra, y en el plano político entre ambas empresas, y se puede decir que en ese aspecto, la cosa anda muy caliente.

Índice de contenidos

Índice de contenidos

Pat Gelsinger afirma que el éxito de NVIDIA en IA es pura suerte

Cuando NVIDIA lanzo por primera vez sus tarjetas gráficas con la GPU Volta en 2017 traían consigo un tipo de unidad inédita en este tipo de chips hasta ese momento, los arrays sistólicos a las que bautizaron como Tensor Cores. Si bien no se trata en realidad de un invento de la empresa de Jensen Huang, no se usaban en chips gráficos. ¿Su particularidad? Está pensada para operar con matrices, lo que las hace ideales para algoritmos de Deep Learning y Machine Learning, dos disciplinas relacionadas con la inteligencia artificial.

Por lo que mirando hacia atrás podemos deducir que NVIDIA tuvo visión al apostar por la IA hace seis años, cuando todo el mundo se preguntaba para qué servían esos Tensor Cores. Pues bien, Pat Gelsinger, el consejero delegado de Intel, no ha dudado en continuar su guerra sobre la IA entre Intel y NVIDIA, la cual ya empezó hace unos días diciendo que su objetivo es desplazar a CUDA del mercado para favorecer a OneAPI. Y ahora de nuevo ha vuelto a atacarles, diciendo que el éxito de la marca verde en dicho campo no se debe a sus esfuerzos, sino a pura suerte, declaraciones que se pueden ver en el vídeo que acompaña estas líneas.

Gelsinger incluso ha mencionado a los fantasmas

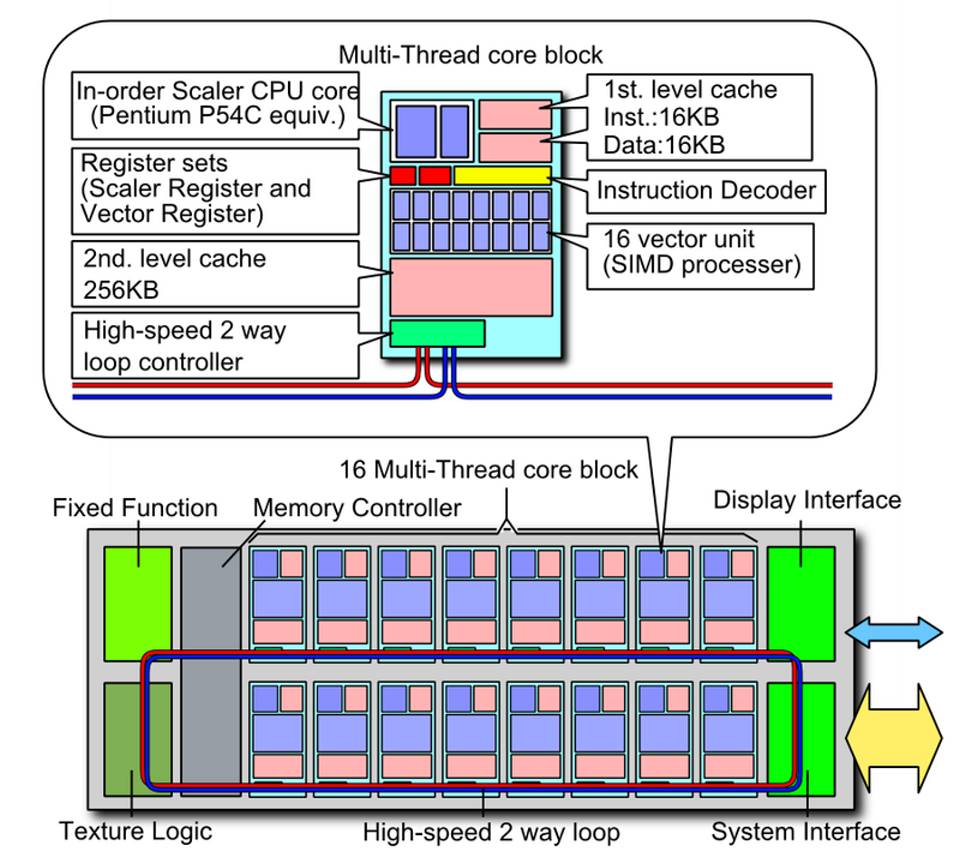

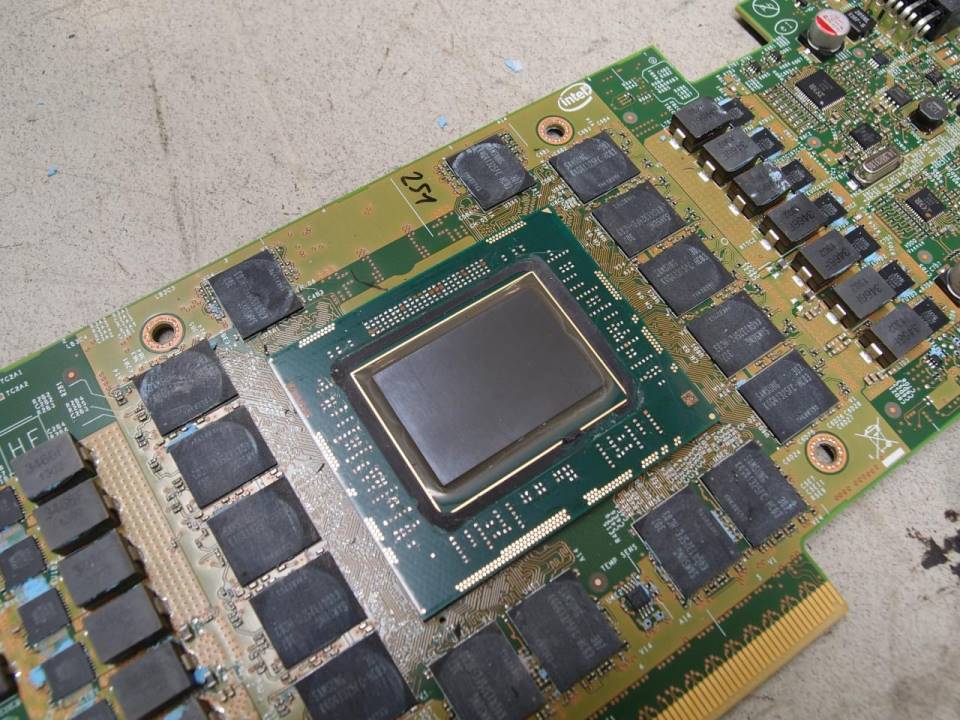

En sus palabras acerca de la guerra de la IA entre Intel y NVIDIA, Gelsinger incluso ha mencionado el proyecto Larrabee, un intento de construir una GPU que hubo a finales de la década de los 2000, utilizando para ello decenas de núcleos Intel Pentium de primera generación, P54C, modificados. El primer Intel Pentium era una CPU superescalar, con un Frontend capaz de procesar dos ejecuciones por ciclo, con ejecución completamente en orden y careciendo de caché L2, que apareció a principios de los 90 para PC.

Intel resucitó en 2007 el P54C para su proyecto Larrabee con el objetivo de vencer a NVIDIA en aquel entonces incipiente mercado de las GPU de alto rendimiento, pero con los siguientes cambios:

- Soporte para multihilo x 4.

- El añadido de una unidad vectorial SIMD16.

- Una caché de segundo nivel de 256 KB para cada núcleo

No se trataba de un chip para gaming, dado que su carencia de ciertas unidades de función fija hacía que su rendimiento en juegos fuese muy malo. El diseño se terminó convirtiendo en los Xeon Phi para ser retirado por completo del mercado por Intel tras fracasar en el mercado de forma estrepitosa, precisamente contra NVIDIA en el intento de dominar el mercado de las GPU para el mercado de computación de alto rendimiento.

La respuesta desde NVIDIA a Pat Gelsinger no se ha hecho esperar

No obstante, a las afirmaciones de Pat Gelsinger se han visto respondidas por Bryan Catanzaro, en una serie de tweets, vicepresidente de NVIDIA en investigación aplicada al Deep Learning, poniendo en su sitio al ridículo intento de Gelsinger de empezar una Guerra de la IA entre Intel y NVIDIA.

Trabajé en las aplicaciones para Intel Larrabee en 2007, entonces me fui a NVIDIA par trabajar en Machine Learning en 2008. Así que estuve en ambos lugares al mismo tiempo y puedo decir que el dominio de NVIDIA no vino de pura suerte, vino desde la visión y la ejecución, la cual Intel careció.

Hubo mucha gente en Intel con la que trabaje que vieron la oportunidad y el riesgo para Intel. Por aquel entonces, NVIDIA era diez veces más pequeña en ingresos, por lo que creían que podían crujir a NVIDIA con Larrabee, pero carecían de visión y ejecución.

¿La realidad de la Guerra de la IA entre Intel y NVIDIA? La marca azul no quiso apostar por dicha disciplina y ahora llora por el hecho que el hecho de ignorar los avances de la computación en todo lo relacionado con las GPU les está pasando factura.