NVIDIA estaría planeando un cambio revolucionario en sus futuras tarjetas gráficas

¿Es posible que digamos adiós a los Tensor Cores en las RTX 50? En ciertos círculos está sonando este rumor, el cual sorprende por el hecho que estas unidades se han convertido en la punta de lanza de NVIDIA en los últimos años. Pero, ¿es posible que los veamos reemplazados por otra cosa?

Índice de contenidos

Tabla de contenidos

¿Diremos adiós a los Tensor Cores en las RTX 50?

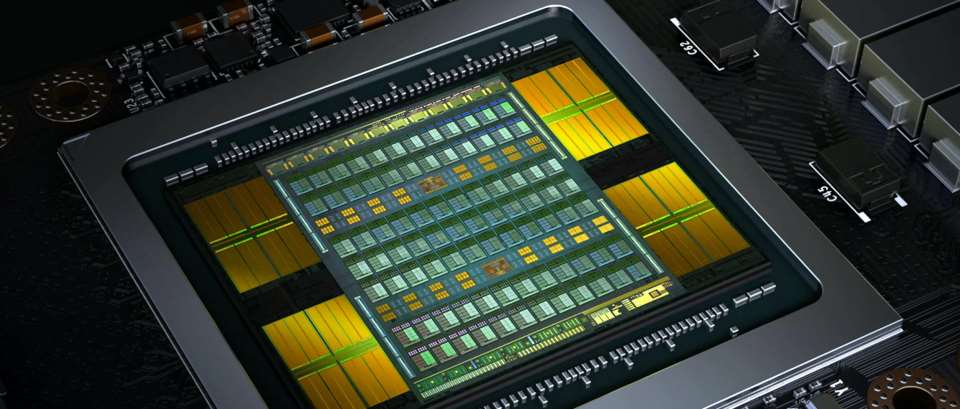

Hace unos días os comentamos que NVIDIA tiene planes para lanzar chips a medida para Deep Learning y Machine Learning, tanto para aprendizaje como para inferencia, fuera de su gama habitual de GPU. Lo cual significa que han tenido que desarrollar un tipo de núcleo o configuración más similar a una NPU y sin los elementos clásicos que tienen los núcleos de una GPU. Es decir, la marca liderada por Jensen Huang habría separado sus SM en dos tipos distintos, al menos eso en principio, lo cual explicaría el posible adiós a los Tensor Cores.

Hemos de partir de que los Tensor Cores son arrays sistólicos dentro del SM, pero comparten los registros con las unidades SIMD. Lo cual significa que no se pueden utilizar ambos al mismo tiempo. Para que lo entendáis mejor, todos esos ratios de Tensor TFLOPS que da NVIDIA en sus especificaciones son falsos por el hecho que no pueden trabajar el 100% del tiempo. Pero, ¿qué ocurre si les damos a los Tensor Cores su propio núcleo? Es decir, su propia caché de primer nivel y registros.

Pues en principio que la potencia total disponible sería mucho más alta, ya que en cualquier momento las aplicaciones tendrían acceso a los Tensor Cores. Todo ello no debería extrañarnos y no es diferente a cuando NVIDIA a partir de Turing desgloso las unidades de enteros y de coma flotante en dos tipos de SIMD distintos. Es más, se trata de una evolución lógica que, como ya hemos dicho, les permitirá diseñar chips puramente pensados para IA para los clientes que no necesitan una GPU.

Un cambio que tarde o temprano tiene que ocurrir

A medida que han ido pasando las generaciones, el set de instrucciones de las GPU de NVIDIA se ha ido volviendo más complejo y esto supone un problema a largo plazo, ya que significa tener un decodificador de instrucciones cada vez más complejo, lo cual significan problemas a largo plazo por ese aumento de complejidad.

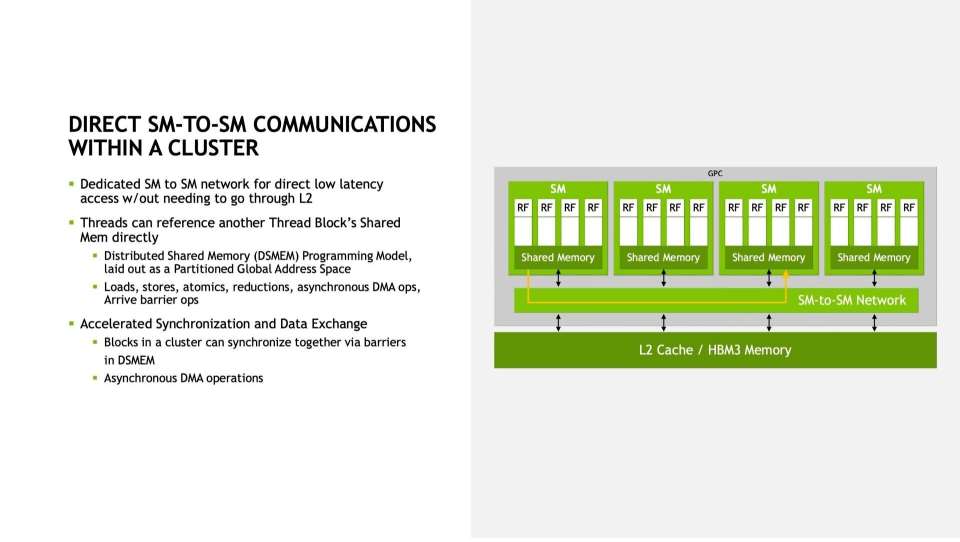

El otro punto que hará que le digamos adiós a los Tensor Cores, es que estos nuevos núcleos no se comunicarán entre si utilizando las cachés, lo cual es ineficiente para este tipo de hardware. Es decir, NVIDIA puede intercomunicar sus núcleos para la IA en matriz sin pasar por las cachés. Una función que ya se encuentra en el chip H100 para HPC, pero que es inédita en las RTX 40, por lo que podríamos verlo en la siguiente generación.

Veremos cómo evoluciona todo esto, y si será algo exclusivo del mercado de computación de alto rendimiento y los diseños a medida de NVIDIA, o si lo veremos implementado de alguna forma en las futuras RTX 50. Ahora solo nos falta esperar para ver si esto se confirma, pero el concepto nos parece interesante a la par que bastante posible.